Osobliwe i niezrozumiałe rysunki odnoszą się do kabalistycznie mistycznego zjawiska, jakim jest wartość średnia. Istnieje teoria, że niegdyś potrafili ją wyliczyć uczniowie podstawówki, ale to było dawno i nieprawda. Adam Cebula wierzy w to, ale średnio.

Przeglądając Internet, zwróciłem uwagę na taką — moim zdaniem — ciekawostkę: banalne pojęcie wartości średniej ma w potocznej mowie inne znaczenie niż w, nazwijmy to szumnie, nauce. Wartość średnia w „zwykłym” rozumieniu jest czymś abstrakcyjnym, nieistniejącym. Wyliczamy średnią płacę… ależ oczywiście, nikt tej średniej nie dostaje. Jedynie cieszy się, gdy jest, i złości, gdy poniżej. Podobnie „średni wzrost” ma znaczenie jedynie, nazwijmy to, dywagacyjne. Wyliczamy tę wartość z premedytacją, celując na to, że np. zupełnie się nam nie przyda przy szyciu ubrań. Jeśli używamy tej średniej (wzrostu) np. do wyliczenia, ile materiału potrzeba na ubrania, to poszliśmy „po najmniejszej linii oporu” czyli linii najmniejszego oporu, czyli sięgnęliśmy po ową statystyczną, oszukaną czy wydumaną wartość, która nadaje się średnio do czegokolwiek. Średnia to coś, co wymyślili niezbyt życzliwi ludzkości matematycy czy jacyś inni dziwacy i służy głównie do wodzenia na manowce (przytaczania w sprawozdaniach) albo do naciągania, ale do niczego praktycznego nadać się nie może.

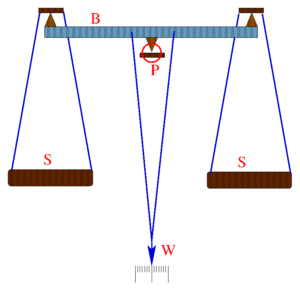

Po co się wylicza wartość średniej w pomiarach? Ano, aby możliwie najdokładniej podać wartość wielkości mierzonej. Wyobraźmy sobie że ważymy coś. Rysunek

(waga.png) pokazuje schemat starej wagi laboratoryjnej. Mamy szalki (S) wiszące na belce (B) oraz wskazówkę W. Ta wskazówka jest ważna w mechanicznej konstrukcji, zwykle na niejumieszczony jest ciężarek, którym reguluje się czułość wagi. Kto nie ważył, ten nie wie, że ważąc, najpierw za pomocą odważników zrównoważamy ciężar tego, co ważymy — tak że wskazówka znajdzie się w zakresie skali — a dokładny odczyt otrzymujemy, sumując z wagą ciężarków i położenie wskazówki.

W jakim miejscu się ona zatrzyma? Teoretycznie tam, gdzie moment siły wynikający z ciężaru i długości wskazówki zrównoważy różnicę momentu siły wynikającego z długości belki, i tego, ile niedoważyliśmy albo przeważyliśmy, kładąc ciężarki. Praktycznie? Będzie gdzieś „około”. Jeśli wyobrazimy sobie pryzmat P w dużym powiększeniu, może to wyglądać trochę podobnie do tego, co namalowałem na kolejnym rysunku .

Zarówno nierówności podłoża, jak i niezwykle starannie wypolerowanego ostrza pryzmatu spowodują, że końcowe ustawienie wskazówki będzie PRZYPADKOWE. Owszem, za bardzo od tego teoretycznego nie może odbiegać, co więcej, im większej sobie zażyczymy odchyłki, tym rzadziej się będzie ona zdarzać, bo potrzeba, by spotkały się ze sobą i odpowiednie nierówności na pryzmacie i podłożu, i prędkość kiwania się belki.

Możemy się spodziewać, że jeśli wykonamy wiele ważeń i wyliczymy wartość średnią, to będzie ona bliższa wartości rzeczywistej niż wyniki z poszczególnych pomiarów. Gdyby ktoś kwestionował istnienie wartości rzeczywistej, to ta wartość średnia będzie bliższa wadze, jaką znajdziemy na urządzeniu o lepszej dokładności.

Może to nie jest bardzo odkrywcze, ale w mowie potocznej wartość średnia jest czymś średnio rzeczywistym, w pomiarach może to być wielkość bliższa niż wyniki wszystkich pomiarów. Ależ oczywiście, jeśli będziemy miarką centymetrową mierzyć dzieci w klasie, i wyliczymy z tego średnią, to będzie ta średnia abstrakcyjna. Ale jeśli będziemy ważyć wiele razy to samo coś, to zupełnie na odwrót. Trzeba myśleć, kiedy który przypadek otrzymamy, ale to już trochę inna para kaloszy. Tak w ogóle planowanie i rozumienie pomiarów to naprawdę bardzo trudna i nieefektowna sztuka, ale o zasadniczym znaczeniu dla nauki. Wiele osób nie rozumie, że teoria to rodzaj karcianych sztuczek. Sztuką jest dopasowanie teorii do pomiarów w taki sposób, by dało się planować kolejne eksperymenty.

W wielu wypadkach wyliczanie owej średniej ma średni sens. Np. w sytuacji, gdy dokładność odczytu jest dużo mniejsze niż dokładność pomiaru. Typowa sytuacja: mierzymy linijką długość ołówka. Gdy mamy dobry wzrok i robimy to starannie, to ilekroć byśmy nie mierzyli, dostaniemy np. 153 mm i „troszkę”. Odmienny wynik nie jest niczym innym, jak tylko efektem błędu, powiedzmy w ustawieniu ołówka. Średnia miałaby sens, gdybyśmy się wzięli za to „coś”.

Ważna sprawa: średnia ma sens, gdy rozrzut wyników jest wynikiem procesów losowych. Do tego chcemy, aby wyniki spełniały warunek tzw. rozkładu normalnego. Nie jest z pewnością dobrym pomysłem wykładanie tu teorii pomiarów i elementów statystyki, ale wskazanie, że działanie wartości średniej w różnych okolicznościach można popsuć. To ważna rzecz. To funkcjonuje, o ile mamy uczciwy chaos, ot co.

Nie zdajemy sobie sprawy, jak często korzystamy z uśrednionych wyników. Nie wiem, czy choćby raz gdzieś przeczytałem, że na tej zasadzie działa zwykłe radio. Mamy w nim urządzenie, które produkuje wartość średnią sygnału radiowego. Dobiega on z anteny do tak zwanego układu rezonansowego. Możemy go sobie wyobrazić jako rodzaj huśtawki. Jeśli popychamy ją w odpowiednich momentach, wówczas rozbuja się mocno. Jeśli nawet silnie popychamy, ale nie w rytmie wahań, amplituda wychyleń będzie niewielka. Ta własność jest najczęściej opisywana, układ działa wybiórczo, faworyzuje pewną częstotliwość, na którą został ustawiony. Ale amplituda wahań jest proporcjonalna do średniej wartości sygnału dobiegającego z anteny, wyliczonej z zwykle z kilkudziesięciu ostatnich wychyleń, czy — jak mówimy uczenie — okresów. Gdy popychamy huśtawkę, możemy na chwilę przestać to robić, będzie się kiwać dalej. Jak szybko maleje amplituda, określa tzw. dobroć układu drgającego. Im ona jest większa, tym kiwanie zmienia się wolniej, zarówno wtedy, gdy huśtawkę popychamy. jak i wówczas, gdy przestajemy. Dokładnie dobroć to stosunek całej energii układu drgającego do energii traconej podczas jednego okresu drgań.

Im większa jest dobroć układu drgającego, po tym większej liczbie okresów uśredniamy amplitudę wahań. Dla układów radiowych na częstotliwości rzędu kilku megaherców owa dobroć wynosi kilkadziesiąt . Ach, muszę dodać, owa dobroć jest wielkością bezwymiarową, bo to dżul podzielony przez dżula. Dla układów na wyższe częstotliwości jest ona większa, wynosi kilkaset, ale specjalne wykonania, tzw. filtry kwarcowe, mają ten parametr na poziomie setek tysięcy. Im wyższa dobroć, tym dłuższy okres uśredniania, tym mniejszy wpływ impulsów docierającego z anteny napięcia, które są w niezgodzie z rytmem kiwania się naszych huśtawek. Elektronicy mówią, że urządzenie ma coraz węższy zakres przenoszonych częstotliwości. To prawda, bo przy długim czasie uśredniania, elektryczne popchnięcia, które tylko nieznacznie różnią rytmem od tego właściwego dla układu rezonansowego, muszą jednak doprowadzić do znacznego spadku amplitudy. Im większa dobroć, tym dłuższy czas uśredniania sygnałów i tym większa selektywność obwodu, czyli zdolność do odsiewania właściwego sygnału od zakłócających.

Łatwo pokazać, że niestety nie można z dobrocią przesadzić. Jeśli odbieramy sygnały Morse’a to musimy odróżnić kropki od kresek, i by tak się działo, układy odbierające sygnały z anteny muszą się przestać bujać w wystarczająco krótkim czasie. Jeśli chcemy słuchać przekazu podawanego ludzkim głosem, ten czas, w którym wahania selektywnych obwodów niemal zanikną, nie może przekraczać jakieś 0,3 milisekundy, by dało się przenieść najwyższe tony, które są ważne w rozpoznaniu poszczególnych głosek. Dla precyzji trzeba by omówić tu szereg możliwych różnych sposobów modulacji fali nośnej. To już coś bardzo odległego od wartości średniej. Powiem tyle, że najprostsza do zrealizowania modulacja amplitudy jest też rozrzutna pod względem zajmowanego pasma, źle nadaje się do wydobywania z zakłóceń za pomocą wąskopasmowych filtrów. Zaś do najbardziej kompaktnej modulacji SSB, która jest mocno zawiła, jeśli chodzi o działanie, i trudna do wytłumaczenia, pasuje dobrze nasze wyliczenie.

W przypadku telegrafii czas zaniku drgań może dojść nawet do 0,1 sekundy. W efekcie bardzo silnie tłumione są sygnały odległe ledwie o kilkaset herców od „naszej” częstotliwości. To naprawdę bardzo mało: przy typowych częstotliwościach 10—20 MHz, używanych np. przez krótkofalowców, 100 Hz różnicy oznacza, że częstotliwości różnią się o jedną stutysięczną. Dlatego łączność telegraficzna jest taka odporna na zakłócenia. Polacy chwalili się, że gdy Amerykanie dokonywali ataku na Irak, pomimo postawienia bardzo silnych zakłóceń polska ambasada ciągle miała łączność.

Przykładem z zupełnie innej parafii, lecz chyba dobrze ilustrującym to, że „im średniej”, tym lepiej, jest uśrednianie obrazów. Z tym zagadnieniem wiąże się pytanie, o ile wyliczenie średniej z próbek zbliża nas do wartości dokładnej. Odpowiedź nie jest zbyt optymistyczna: jest lepiej o pierwiastek z liczby n. W przypadku obrazów mamy mnóstwo pikseli. Wyliczenie średniej powoduje, że rozrzut (to w tym wypadku bardzo nieprecyzyjne, ale intuicyjne pojęcie) ich wartości wokół wartości prawdziwych zmniejsza się 10 razy, jeśli każdy został wyliczony ze stu próbek. Po prostu robimy sto zdjęć tego samego planu, następnie z tych stu zdjęć tworzymy nowe w ten sposób, że wartość każdego piksela wyliczmy, biorącten sam co do pozycji na zdjęciu piksel z każdego ze stu zdjęć, i wyliczamy wartość średnią.

Jak działa taka operacja, pokazują zdjęcia. Na pierwszym mamy jedno ze stu dwudziestu siedmiu zdjęć składowych,

na drugim efekt uśrednienia.

Musze od razu zaznaczyć, że aby uzyskać tak zaszumione zdjęcie, musiałem się trochę namęczyć. Na czułości ISO 25600 w Canonie 700D musiałem ustawić korekcję ekspozycji -3 EV. Jest to skrajnie wysoka czułość i skrajne niedoświetlenie. Mam nadzieję, że udało mi się uzyskać odpowiedni dla popularyzacji efekt.

Operację uśredniania wykonałem za pomocą programu convert poleceniem convert *.jpg -evaluate-sequence median wyjsciowy.jpg . Uwaga! Na końcu polecenia nie ma kropki, tu wzięła tylko z powodu zaznaczenia końca zdania. Program convert instaluje się w systemach Linux w pakiecie ImageMagick (pl.wikipedia.org/wiki/ImageMagick). Jest to oprogramowanie Open Source, oczywiście darmowe, z mnóstwem możliwości. Charakterystyczną jego cechą jest to, że wywołujemy programy z wiersza poleceń. Z jednej strony to „ściana” do pokonania dla nowicjuszy, z drugiej daje wielkie możliwości w manipulowaniu tymi programami.

Tak poniekąd na marginesie tematu średniej: do czego praktycznie uśrednianie obrazów może się przydać normalnemu pstrykaczowi? Muszę przyznać, że jeszcze jakieś dziesięć lat temu pewnie odpowiedziałbym bez wahania, że do robienia zdjęć w trudnych warunkach oświetleniowych. Dziś, gdy aparaty sięgnęły czułości sto tysięcy ISO, trudno znaleźć takie warunki, gdzie naprawdę podobna operacja da duży korzyści. Typowym trudnym miejscem dla fotografa było muzeum: nie wolno chodzić ze statywem, nie wolno używać lampy błyskowej. Jednak współczesne aparaty z obiektywami ze stabilizacją i wspomnianymi niesamowitymi czułościami (a do tego jasne obiektywy) praktycznie załatwiają sprawę.

Na problem możemy trafić, gdy uprzemy się robić nocne zdjęcia za miastem. Tam może być dość ciemno. Wówczas nie ma wyjścia, bo mamy zjawisko spadku czułości nośników z wydłużaniem się czasu naświetlania.

Jest to efekt Schwarzschilda (http://pl.wikipedia.org/wiki/Efekt_Schwarzschilda). W aparatach cyfrowych prowadzi do tego, że w pewnym momencie dalsze naświetlanie nie daje już żadnych efektów. Film ma taką przewagę, że można go pomęczyć kilkadziesiąt minut i będzie dobrze. W cyfrze jest znacznie gorzej. Można się uratować tylko w ten sposób, że ustawimy dużo większą czułość, niż chcielibyśmy ze względu na szumy, i wykonamy serię zdjęć. Z zasady, że szumy maleją z pierwiastkiem liczby próbek, wynika że czas tej operacji będzie długi, dłuższy niż naświetlanie filmu. Lecz skoro nie mamy filmu…

Inna sytuacja, która może być głupim pomysłem ( bo moim autorskim), to doświetlanie planu lampą błyskową. To nam się może przytrafić, gdy wpadniemy na pomysł użycia lampy w terenie. W przypadku lamp błyskowych czas naświetlania nie powinien być dłuższy niż czas wynikający z odpowiedniego stosunku światła zastanego do błyskowego. Jeśli musimy ustawić wysokie ISO, mamy patent, jak się pozbyć szumów.

Uśrednianie obrazów możemy wykorzystać do ratowania zdjęć robionych z ręki w trudnych warunkach. Jak? Ręka się trzęsie. Nie tylko w kompromitujących okolicznościach. Dla fotografii dość stabilny jest jedynie statyw. Lecz wykonujemy serię zdjęć z ręki, starając utrzymać aparat możliwie nieruchomo. Następnie za pomocą specjalnego oprogramowania dopasowujemy je do siebie. Takim dobrym oprogramowaniem w Linuksie jest pakiet Hugin (http://pl.wikipedia.org/wiki/Hugin_%28program%29) .

Ten program umie „coś zrobić”, nie jest to tylko proste przesuwanie obrazów w taki sposób, że będą one do siebie pasowały prawie piksel w piksel. Część kadru zostanie pewnie wycięta, ale to, co zostanie, może zostać poddanie operacji wyliczania wartości średniej.

Jeśli mamy zainstalowany pakiet ImageMagick i Hugin, możemy posłużyć się w Linuksie takim prostym skryptem:

#!/bin/bash

align_image_stack -m -a wyj_PREFIX *.JPG

convert wyj_PREFIX* -evaluate-sequence median wyjsciowy.jpg

Skrypt wgrywamy do osobnego katalogu, przenosimy do niego serię zdjęć, które mają być uśrednione. Plik skryptu musi mieć ustawione prawo do wykonywania. Uruchamia się go poleceniem ./moj_skrypt.txt (o ile plik skryptu nazwaliśmy moj_skrypt.txt).

Uwaga na miny, jakie tu występują. Pierwsza linijka po inwokacji „#!/bin/bash” produkuje tify (taki typ pliku obrazkowego) o nazwie zaczynającej się od „wyj_PREFIX”. Po nazwie zostanie dodany numer pliku. Niestety na końcu linijki jest „*.JPG” To oznacza, że chcemy wczytać wszystkie pliki, które kończą się właśnie tak: kropka i dużymi literami JPG. Jeśli wczytane zdjęcia są w innym formacie, np. png, czy maja rozszerzenie pisane małymi literami, musimy to zmienić w poleceniu. Katalog musi się znajdować na partycji, gdzie będzie dość miejsca, by się zmieściły nasze pliki tif. Program wyprodukuje uśredniony obrazek o nazwie wyjsciowy.jpg. Oczywiście można sobie wpisać inną dowolną nazwę.

Postęp odbywa się prawie wyłącznie w głowie. To nie może być tak, że ojciec zbudował cudowną maszynę, a syn, pracując na niej, uczy się robić coraz lepsze rzeczy i używa jej lepiej od ojca. Syn w pewnym momencie musi zbudować nową maszynę. Postęp to idee, przepisy, to wiedza. Ta wiedza przybiera czasami efemeryczną postać matematycznych procedur. W przypadku techniki cyfrowej przełożenie matematyki na konkretne zastosowanie bywa automatyczne. Gdy ktoś rzuci ideę uśrednienia zdjęć, wiadomo, co zrobić: piszemy program. W przypadku odbiornika radiowego realizujemy ideę za pomocą fizycznego układu, który działa wedle naszego pomysłu. Aby sprawnie zaprojektować urządzenie, musimy mieć całkiem sporo wiedzy w głowie, na przykład dobrze rozumieć działanie parametru układu drgającego zwanego dobrocią.

Ciekaw jestem natomiast, ile osób uwierzy, że w przypadku ważenia mamy szansę przesunąć granicę dokładności następującą procedurą. Po pierwsze, musimy sobie zapewnić, by dokładność odczytu położenia wskazówki wagi była większa niż mieliśmy do tej pory. Zwykle wagi są projektowane tak, że zatrzymuje się ona przy ważeniu tego samego ciała w okolicy tego samego miejsca na skali, gdzieś pomiędzy trzecią a czwartą kreską, i ile razy byśmy nie ważyli, to będzie wyglądało podobnie. Trzeba np. zrobić sobie tzw. świetlną skalę za pomocą lusterka przymocowanego do belki albo banalnie przedłużyć wskazówkę. A potem zwyczajnie ważymy ciało, zapisujemy wynik, potem delikatnie potrącamy wagę i znów zapisujemy wynik (zapomnijmy o metodzie wyliczania środka wahań). I tak wiele razy. A na koniec — liczymy średnią.

Cóż, pewnie ten tekst jest średnio ciekawy, ale chciałem powiedzieć tyle: opisałem jedno z bardzo mocnych, bardzo uniwersalnych narzędzi, i jedyne czego potrzeba, by je mieć, to zrozumieć.

Adam Cebula

Pobierz tekst:

Adam Cebula „Ósme przykazanie na rok 2019”

Dawno temu wyczytałem, czemuż to poważny czytelnik nie sięga po fantastykę naukową.…

Adam Cebula „Woda utleniona w medycynie ludowej”

Nie znam się na medycynie. Podobno wszyscy Polacy są znakomitymi medykami, lecz nie ja. Wręcz przeciwnie, jak…

Adam Cebula „Wykluczenie elektryczne”

Naszła mnie kiedyś pewna bardzo zatroskana kobieta. Zadała kilka pytań i oznajmiła, że jestem…

Namysłów

Namysłów 26.04.2024 - 28.04.2024

26.04.2024 - 28.04.2024